Her mit den KI-Budgets! Bei generativer KI haben wir jetzt Investitionssicherheit – sagt dieses Paper. Das steht drin:

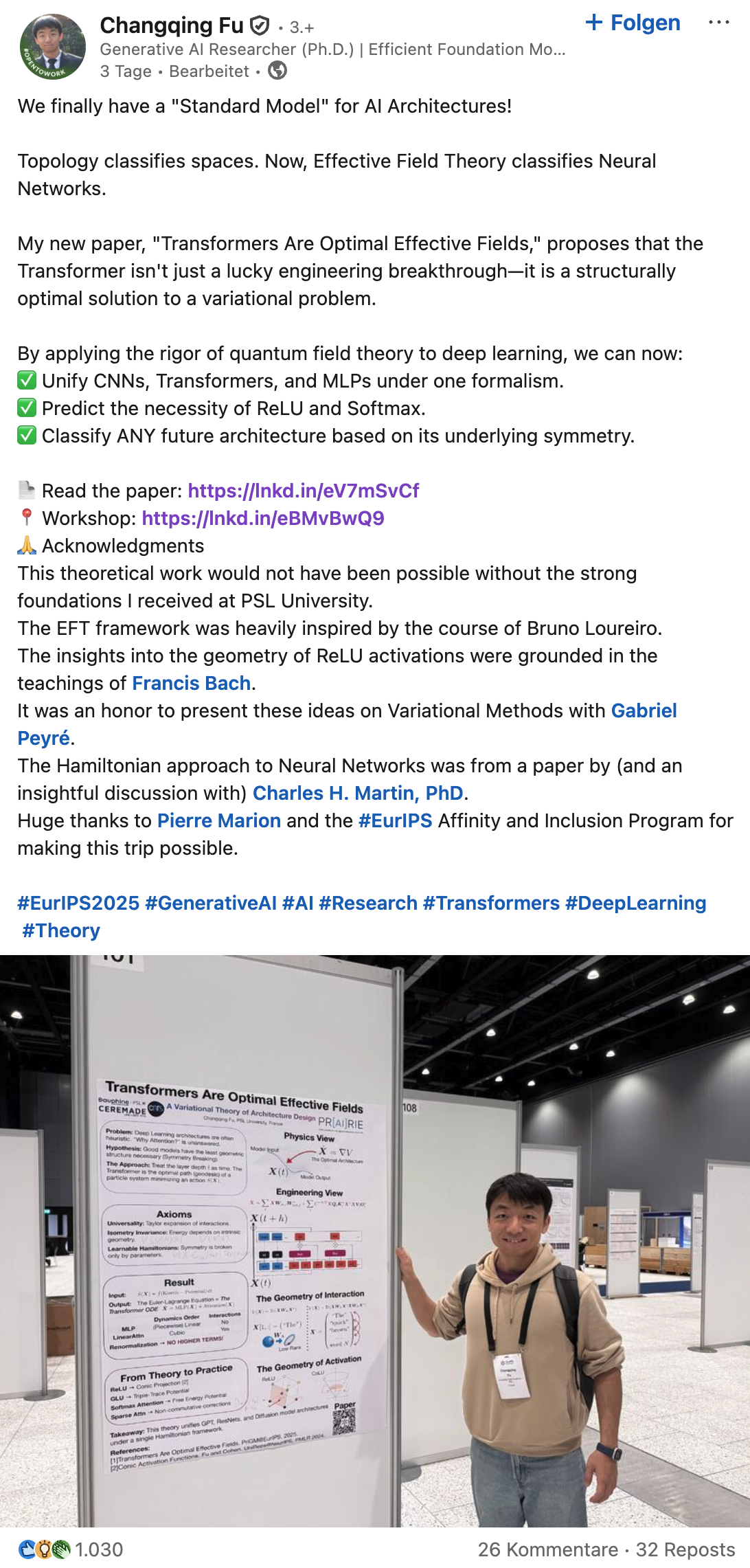

Der Mathematiker Changqing Fu (PSL, Paris) argumentiert in seiner Forschungsarbeit „Transformers Are Optimal Effective Fields“ (https://lnkd.in/eV7mSvCf), dass die Architektur hinter GPT & Co. – die bekannten Transformer-Modelle – nicht einfach ein glücklicher Engineering-Zufall ist, sondern sich mathematisch als naheliegendste und „einfachste sinnvolle“ Lösung für komplexe Informationsverarbeitung begründen lässt.

Oder anders: Unter den allgemeinen Annahmen zeigt sich: Wenn man komplexe Informationen flexibel verarbeiten möchte, landet man fast automatisch bei so etwas wie einem Transformer.

Wenn sich das bestätigt, heißt das übersetzt:

▶️ Die Grundtechnologie moderner LLMs ist stabil – wir reden über Weiterentwicklungen und Leistungssteigerungen, nicht jedes Jahr über völlig neue Paradigmen.

▶️ Auf Basis dieser Architektur lassen sich bereits heute sehr unterschiedliche Domänen abdecken: Texte, Code, Bilder, Dokumente, Wissensarbeit, Prozesse in Logistik, Medizin, Versicherung, Verwaltung usw.

▶️ Selbst wenn eine spätere AGI einmal komplexere Systeme aus mehreren Bausteinen braucht, wird der Kernbaustein für Sprach- und Wissensverarbeitung mit hoher Wahrscheinlichkeit sehr ähnlich zu den heutigen Transformer-basierten LLMs bleiben.

Für Unternehmen ist das der entscheidende Punkt:

Wer damit beginnt, Prozesse, Entscheidungen und Wissensarbeit systematisch mit LLMs zu unterstützen, setzt auf eine Technologie, die uns voraussichtlich langfristig begleiten wird.

Nicht als nettes Add-on, sondern als Infrastruktur-Schicht der digitalen Wertschöpfung.

Es geht daher weniger darum, aus Angst vor der „nächsten großen KI-Technologie“ abzuwarten, sondern darum, diese bestehende Infrastruktur jetzt in Kernprozesse, Organisation und Governance zu integrieren – damit heutige Investitionen nachhaltig wirken und sich über die nächsten Jahre skalieren lassen.

Natürlich wird die Entwicklungsgeschwindigkeit nicht nachlassen und wir werden alle paar Monate über neue Möglichkeiten der KI-Modelle staunen. Die Wahrscheinlichkeit, dass wir mit einer durchdachten Implementierung diese Features ohne fundamentale Anpassungen nutzen können, ist jetzt gerade deutlich größer geworden.